用户体验中的道德设计:别让产品“套路”了用户

更新时间:2025-09-26 17:29:33

用户体验中的道德,就是在数字产品设计与交互流程里,确保尊重用户意愿、信息披露透明、不给用户制造负担或误导。比如电商在结算页自动勾选“赠送保险”,稍不注意就被加了费用;或者在取消订阅时设置极难找到的按钮,几经寻找和折腾才退出,这些都是道德设计缺失的案例。正如学者祖博夫在《监控资本主义时代》中所言,技术设计不再是中性的,它是一种“塑造未来社会的权力”。因此,理解用户体验中的道德,不仅有助于提升用户满意度、信任度,还能降低投诉与法律风险。在这篇文章里,我们将从多个维度解析道德设计的概念、原则、危害与实战案例,并结合好用的提效设计工具,说明如何在产品流程中融入道德考量,让你的 UX/UI 设计既专业又有温度。

1、什么是道德设计?如何理解伦理设计视角

道德设计(也常称为伦理设计)指的是:在交互界面、信息流程、提示语言、默认选项等环节,设计师有意识地把 —— 用户权利、透明知情、平等选择 —— 纳入判断标准,从而避免误导、操控、隐藏成本等行为。应用这种设计思路,就不仅追求效率或转化率,更把尊重用户为一项基本原则。

道德设计是设计思路和周期

从伦理设计视角来看,不只是怎样能让更多人点击,也不仅意味着遵守法律,它更强调设计师在产品中如何体现责任与公平:这样设计是否对用户公平?是否能让用户理解?是否在尊重其选择基础上引导?设计者需意识到:任何一个按钮、默认值、文案措辞,都可能带来诱导效果。若缺乏道德审视,就容易滑向所谓“暗黑 UX”(Dark UX)那条危险边界。

2、不道德设计的危险:暗黑 UX 模式

2.1 暗黑 UX(Dark UX )是什么?

暗黑 UX 是指那些通过界面设计、文案措辞、默认选项、路径布置等方式,诱导、误导或强迫用户做出某种行为,而非让用户在清晰知情情况下自主决策。例如:

-

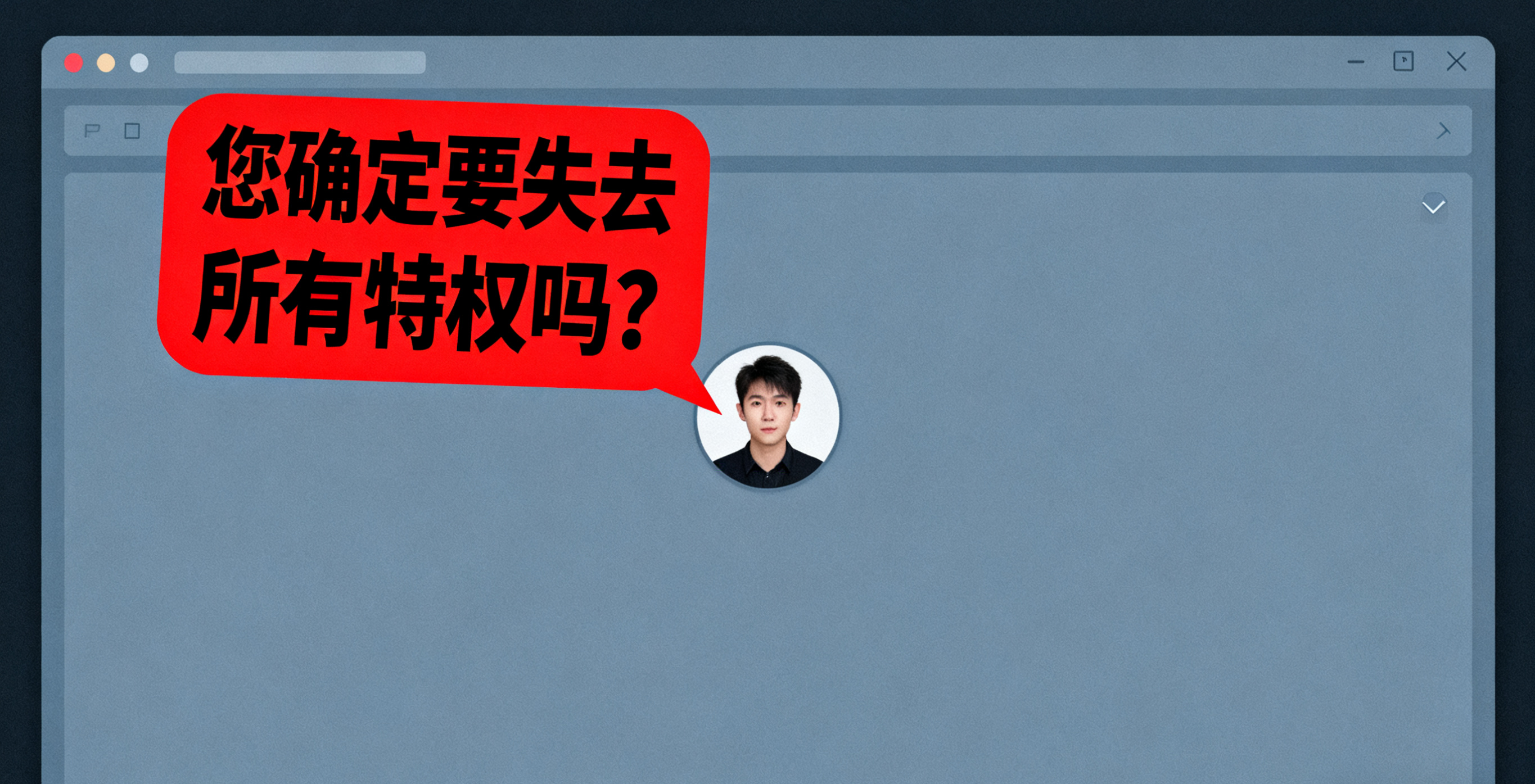

隐藏“取消订阅”的入口

-

用羞辱性语言劝阻用户退出

-

设置自动续费并弱化提醒

UX设计中的不道德诱导行为

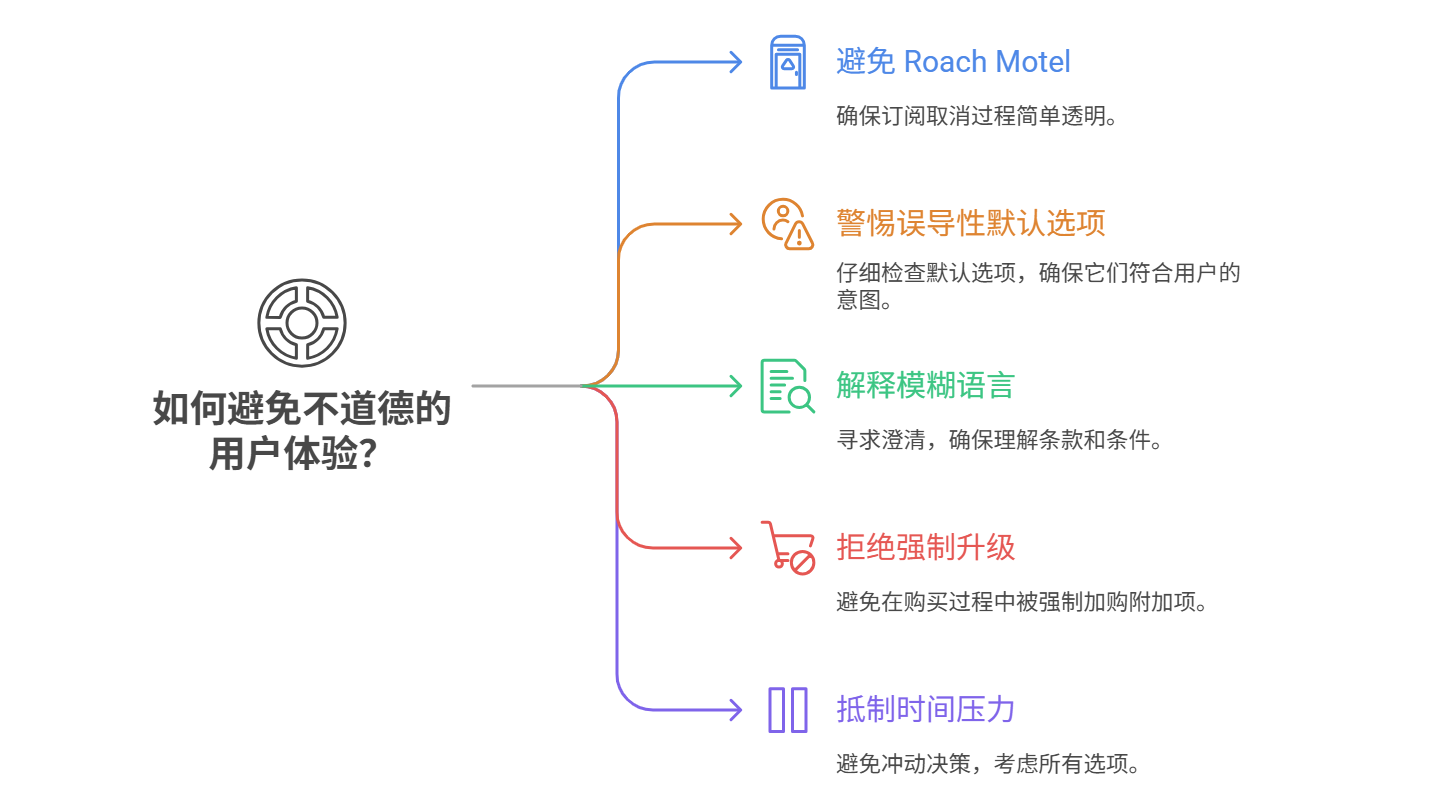

2.2 常见类型与机制

-

Roach Motel(容易进入难退出):订阅很容易,取消极其困难。

-

误导性默认选项:自动勾选某种服务或保险,用户可能未察觉。

-

模糊语言:用模糊措辞、双重否定、隐藏条款,使用户误解真实含义。

-

强制隐性升级:在购买流程跳转时强制加购附加项或套件。

-

时间压力和紧急感:在界面显示“仅剩 1 个库存”“限时优惠”诱导冲动决策。

不道德的用户体验及如何避免

这些模式短期可能提高转化率,但长期会削弱用户信任,损伤品牌形象,甚至触发法律制裁。近年媒体指出,许多订阅服务被监管机构调查就是因为用户难以取消。2023 年,欧盟出台的《数字服务法案》已经明确要求企业避免使用误导性设计模式,这正是对用户体验设计规范提出更高要求的体现。

2.3 暗黑 UX 在 AI 时代的新挑战

随着 AI 算法推荐机制加深,暗黑 UX 的形态可能更隐蔽:系统自动调优哪种按钮更易点击、在用户犹豫时触发升级提示、自动调整显示次序诱导用户点击等。优化目标若更加偏重商业指标,就可能在不自觉中侵犯用户选择权。

3、透明性:设计为何需要让用户看清楚

3.1 用户体验透明性的含义

在用户体验中,透明性意味着:在任何过程中,数据如何被收集?功能为什么被设计?他们的选择会带来什么结果?如果缺乏透明性,用户很容易在使用过程中感到被欺骗或操纵,从而失去对平台的信任。

-

苹果的“应用跟踪透明度”机制赋予用户知情权,让他们可以自由选择是否允许跨应用跟踪。

-

谷歌的“隐私沙盒”则尝试在保护用户隐私和保障广告生态之间找到平衡。

3.2 透明性为何重要

-

建立信任:让用户知道“发生了什么、为什么这样、我的选项是什么”。用户如果感到被蒙在鼓里,可能失去对品牌或产品的信任。

-

法规遵循:近年隐私保护法规(如 GDPR、各国个人数据法)对“知情同意”“选择权”有明确要求。

-

选择自治:在透明背景下,用户可更好判断是否继续、放弃或修改自己的选择。

-

减少纠纷:清晰披露可减少因误解而来的投诉和声誉风险。

举例来说,若某个推荐算法用于向用户推送内容,应在显著位置说明“此为系统推荐”而非用户主动选择,而不是让用户默认认为这些内容全由其自己选取。

而在实际工作中,团队往往需要高效地验证和迭代设计思路。即时设计的优势就很突出,它支持团队实时协作和快速原型测试,可以让用户研究结果更直观地落地为透明的界面方案。

👇点击下方图片,即可免费体验即时设计的协作原型,让设计更开放、更透明~

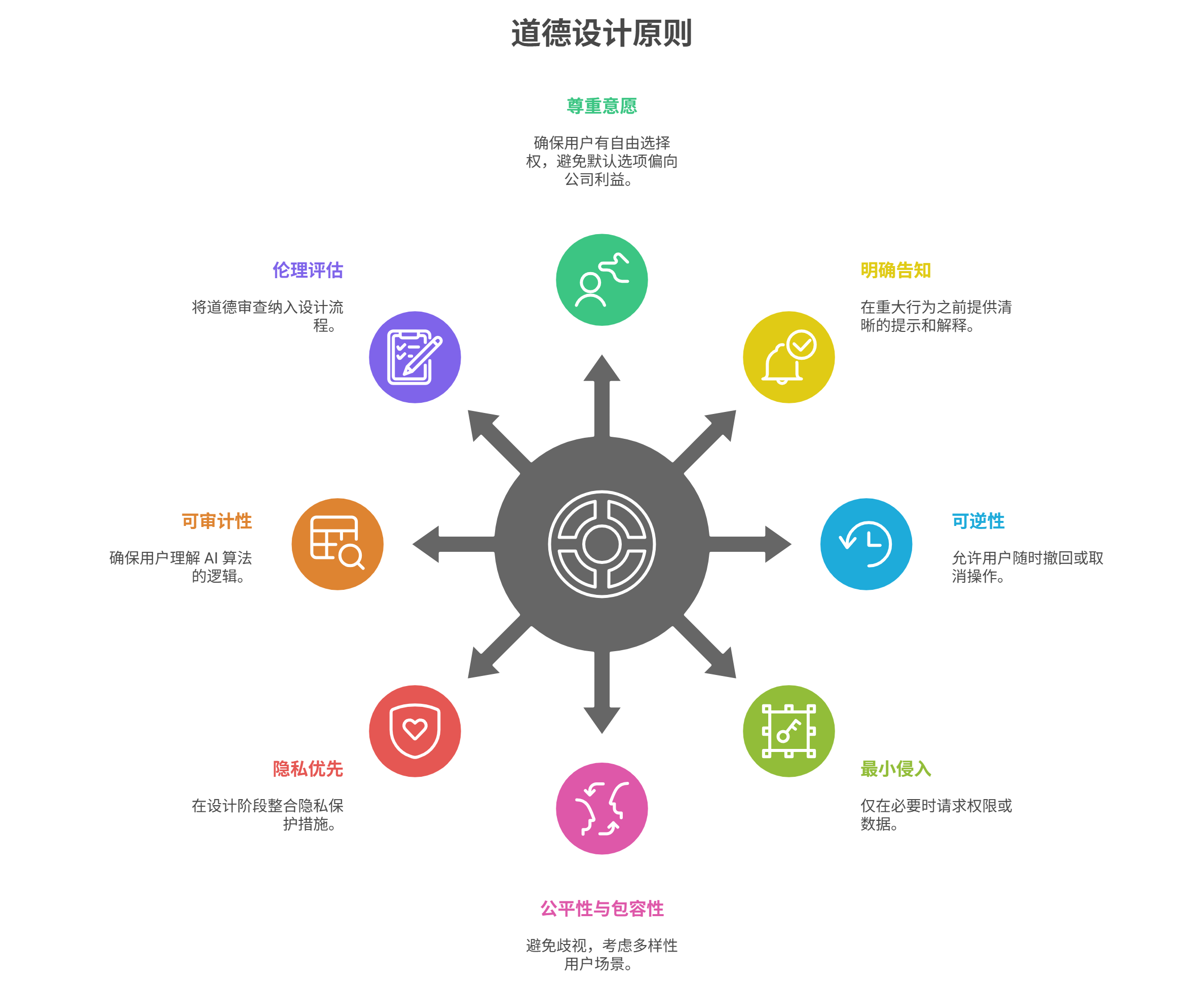

4、道德设计准则与原则

下面是几个业界较为通行、可操作的道德设计原则:

-

尊重意愿:应该保证用户有自由选择权,默认选项不应倾向公司利益。

-

明确告知:在重大行为,比如收费、权限、注销等之前,必须有清晰提示。

-

可逆性、易退出:用户操作能随时撤回、退出、取消。

-

最小侵入:只在必要时申请权限或采集数据,不随意请求额外权限。

-

公平性与包容性:不得歧视特定群体,应考虑多样性用户的使用场景(无障碍、文化差异等)。

-

隐私优先:在设计阶段就把隐私保护融入,而不是事后补救。

-

可审计、可解释性:若系统使用 AI 或算法推荐,应让用户理解其基本逻辑。

-

伦理评估流程:将道德设计审查纳入设计流程,就像 QA 审查、可用性评估那样。

道德设计原则与准则

在具体产品设计与研究过程中,要把“道德标准”“用户体验透明性”融入日常流程,就需要设计、原型、调研工具支持这一理念。在这方面,即时设计提供一些贴近实战的优势,能够帮助 UX / UI 设计师和用户研究者在流程中更自然地考虑道德因素。

例如:在一个订阅服务产品中,设计团队可以用即时设计快速生成两个版本:一个是“默认勾选保险 + 淡化提示”,另一个是“默认不选 + 明显提示 + 一键取消路径”。通过可用性测试比对用户在两版中的决策行为与理解差异,就能依据用户反馈更好地选择具有道德性的设计版本。用户研究者可以在观察、访谈、问卷调查后,在即时设计里记录用户对“提示清晰度”“选择控制感”的评价,并据此优化流程。如果你需要制作用户研究的模版,可以点击下方图片👇直接获取模版哦~

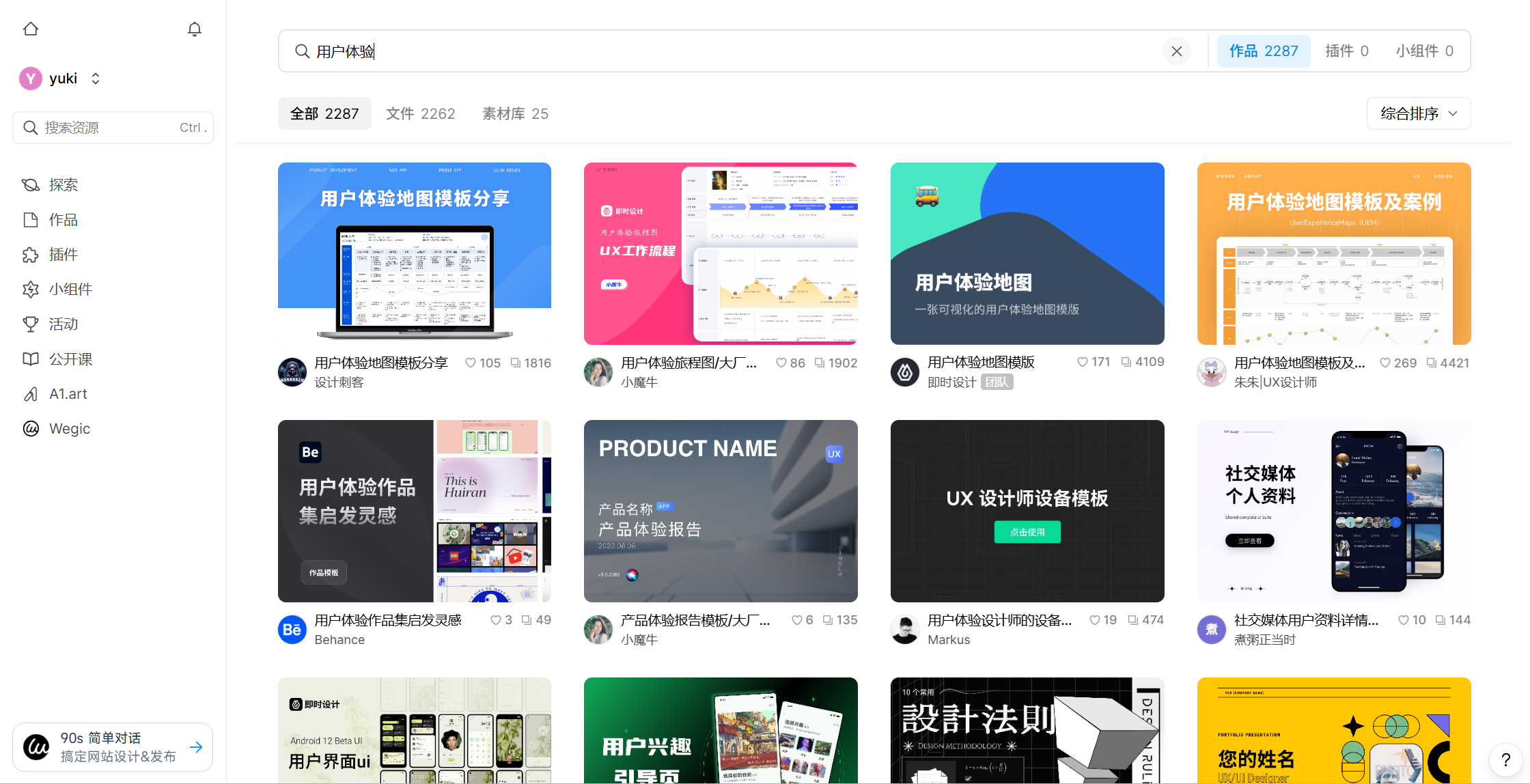

你还可以直接去即时设计资源社区中套用现成的用户体验模板,直接开始尝试在文件中练习道德设计的具体实操。

👇点击下方图片,即可免费使用即时设计用户体验模板

通过这种方式,你可以在真实项目中自然地将用户体验中的道德嵌入每一个交互节点,而不是事后反思。随着越来越多设计师采用该方式,整个 UX / UI 生态将更加重视道德考量。

5、2025 年最新用户体验中的道德实践案例

以下是几家在道德 UX 设计方面已有推动或规范实践的企业和组织:

-

Google 的 AI 透明标签与可解释性举措

在推进用户体验中的道德过程中,Google 最近在其产品中进一步强化对 AI 内容的透明标注机制。2024 年 10 月,Google 表示将在 Photos 应用中显示“此图像已通过 AI 工具编辑 / 生成”的标签 —— 这些信息会与照片的文件名、拍摄地点、备份状态等一同展示给用户。

这背后的思路是:如果用户能“看到”算法的存在,不再把所有结果都当作“自然产出”,那么他们就更可能保持一种审慎的使用态度。近期一项关于 AI 内容标注的实验研究也表明,当社交媒体内容带有“AI 生成”标签时,用户更倾向认为这是机器生成内容,虽然标签本身并不总能改变用户点赞、分享的互动行为。这说明,标签确实在用户理解层面产生“透明效果”,但还不一定能彻底改变行为。

把这个比作一盏指路灯:在用户进入复杂黑箱模型内部时,至少给他们一点光,让他们知道自己正处在那条通道里,而不是迷失在无意识的流程中。

-

微软的 GitHub Copilot 的可控提示设计

在 Copilot 等 AI 辅助工具中,微软有意识地为用户保留一些回旋余地:他们在界面中加入“反馈”“撤销建议”的路径,并在某些环境下标注“这些内容由模型生成”。这使得用户对 AI 建议有可控性和辨识度,让它不再像“靛蓝屋顶上的迷雾”那样神秘无感。

例如,当 Copilot 计划使用用户反馈数据训练其 AI 模型时,微软承诺:用户可以选择退出(opt-out),并且此类训练只有在用户收到通知 15 天后才开始生效。

-

Netflix:内容透明提示

在视频流媒体领域,Netflix 长期以来通过内容分级(PG-13、R、NC-17 等)与标识敏感内容策略,让用户能够在进入播放前就获得判断依据。这就是一种用户体验透明性的体现——不是让用户被动进入,而是让他们在决策前就有信息。在某些地区,Netflix 对包含强烈暴力、色情、恐怖内容的视频还附上“警示条”或“家长锁提示”,用户可据此自主决定是否打开。这样的设计思路,在道德维度上帮助用户更好地控制自己接触内容的边界。

结语

在数字时代,产品体验其实更重要的部分是信任、尊重、责任的综合判断。用户体验中的道德不仅是设计师的一道自律底线,也正逐渐成为用户选择品牌和产品时的重要考量。只有在交互流程中坚持透明、可控、尊重选择的规范,才能让用户主动愿意信任你的产品。若你正在做用户研究、UX 或 UI 设计工作,希望把专业能力与社会责任结合起来,不妨在实际项目中尝试将道德设计纳入你的流程标准 —— 若你希望有一个能够支持插入说明性提示、可用性测试、版本对比的工具来辅助落地道德考量,建议你注册并使用即时设计。借助这样的工具,你既能在流程中融合用户体验中的道德,也能让你的设计更具说服力、更贴近用户、更可持续。希望这篇文章对你在职业实践中有所启发,也期待未来更多产品在用户体验中的道德这条路上走得更远、更坚实。